OpenAI GPT Token Guide — Tokensystem erklärt

Was sind OpenAI GPT Tokens?

Token sind die Basiseinheit, die OpenAI GPT-Modelle (einschließlich ChatGPT) verwenden, um die Länge eines Textes zu berechnen - und damit auch den Preis der API zu bestimmen. Sie sind Gruppen von Zeichen, die manchmal mit der Wortanzahl übereinstimmen, aber nicht immer. Wie viele Token ein Text lang ist, hängt von der Anzahl der Zeichen, der Textsprache und von Satzzeichen oder Emojis ab. Somit ist die Anzahl an Token häufig größer, als die Anzahl an Wörtern.

Wie zähle ich Tokens in meinem Text?

Um genau zu wissen, wie viele Tokens dein Text lang ist, muss dein Text “tokenisiert” werden. Das ist gar nicht so schwierig, wie es klingt. Du kannst einfach dazu den offiziellen Tokenizer von OpenAI verwenden.

Der offizielle Tokenizer von OpenAI

Beachte, dass der Tokenizer für die verschiedenen GPT-Modelle andere Tokenwerte ausgibt. Wie dein Text “tokenisiert” wird, variiert nämlich zwischen den verschiedenen GPT-Modellen von OpenAI. Momentan verfügbar ist das Tool für GPT-3, GPT-3.5, GPT-4 und bald auch GPT-4o.

Faustformel für das Verhältnis zwischen Wörtern und Token

Da alle Zeichen eines Wortes zum Teil unterschiedlich zählen, ist das Verhältnis von Wörtern zu Token sprachabhängig. Ein Beispiel:

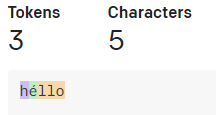

Englisch: “hello”

Deutsch: “hallo”

Französisch: “héllo” (fiktives Wort mit accent aigu)

Trotz gleicher Zeichenanzahl ist der “Tokenverbrauch” für Deutsch und Französisch größer, als der für das englische “Hello”. Selbstverständlich braucht man auch in anderen Sprachen mehr Zeichen oder Wörter, um etwas zu beschreiben, sodass sich die Tokenanzahl dadurch nochmals erhöht.

Bewährte Faustregel für das Verhältnis

Im Englischen: 1 Wort ≈ 1,3 Token

Im Deutschen: 1 Wort ≈ 1,8 Token

Im Spanischen: 1 Wort ≈ 2 Zeichen

Im Französischen: 1 Wort ≈ 2 Zeichen

Um mehr zu dem Verhältnis zwischen Wort und Token und dem dazugehörigen OpenAI API Preis zu erfahren, nutze unseren OpenAI API Preisrechner.

GPT 4o

Beachte, dass mit dem Update auf GPT-4o das Sprachmodell für verschiedene Sprachen aktualisiert wurde, sodass auch der Tokenverbrauch sinkt. Bei dem neuen GPT-4o Modell reduzieren sich die Token wie folgt:

Im Deutschen: 1.2x mal weniger Tokens.

Im Englischen: 1.1x mal weniger Tokens.

Im Spanischen: 1.1x mal weniger Tokens.

Im Französischen: 1.1x mal weniger Tokens.

Mehr Informationen dazu findest du im OpenAI Tokenizer und auf der Ankündigungsseite zu GPT-4o.

Wie viele Token brauchen Satzzeichen, Sonderzeichen und Emojis?

Satzzeichen (,:;?!) = 1 Token

Sonderzeichen (§√×°«) = 1 bis 3 Token

Emojis (😉😎😁) = 2 bis 3 Token

Wie hoch ist der Preis eines Tokens?

Der Preis eines Tokens hängt vom jeweiligen OpenAI GPT-Modell ab. Nachfolgend findest du den Preis für jeweils 1000 Token:

| GPT-Modell | Technischer Name | Preis für 1 Mio. Tokens (Input) | Preis für 1 Mio. Tokens (Output) |

|---|---|---|---|

| GPT-4o (128k) | gpt-4o | USD 5 | USD 15 |

| GPT-4 Turbo (128k) | gpt-4-turbo | USD 10 | USD 30 |

| ChatGPT 3.5 Turbo (16k) | gpt-3.5-turbo | USD 0.50 | USD 1.50 |

Aktueller Stand | (x) max-Token-Angabe der GPT-Modelle.

Was bedeutet der max_tokens Parameter?

Max_tokens ist die maximale Anzahl von Token, die bei einer Anfrage an die OpenAI API von den GPT-Modellen generiert werden soll.

| GPT-Modell | Technischer Name | Max. Tokens |

|---|---|---|

| GPT-4o (128k) | gpt-4o | 128,000 |

| GPT-4 Turbo (128k) | gpt-4-turbo | 128,000 |

| GPT-4 (32k) | gpt-4-32k | 32.768 |

| GPT-4 (8k) | gpt-4 | 8.192 |

| ChatGPT (16k) | gpt-3.5-turbo-16k-v | 16.384 |

| ChatGPT (Standard - 4k) | gpt-3.5-turbo-v | 4.096 |

| Davinci (4k) | text-davinci-003 | 4.097 |

| Curie (2k) | text-curie-001 | 2.049 |

| Babbage (2k) | text-babbage-001 | 2.049 |

| Ada (2k) | text-ada-001 | 2.049 |

Quelle: OpenAI Documentation | -v steht für die aktuelle Versionsnummer

Es sollte folgende Regel beachtet werden:

prompt_tokens + max_tokens ≤ model limit

Beachte, dass wie erwähnt Tokens ≠ Wörter sind. Benutze zum groben Überschlagen die Faustregeln oben.

Wieso ist bei mir die Antwort der GPT-API abgeschnitten?

Wenn die Antwort von der OpenAI API abgeschnitten ist, bedeutet das höchstwahrscheinlich, dass der von dir angegebene max-tokens Parameter nicht groß genug ist. Du solltest den max-tokens Parameter erhöhen.

Wörter und Token Beispiele (GPT-3)

Prompt: Was sind ChatGPT Token?

ChatGPT-Token sind die grundlegenden Einheiten, in die der Text für die Verarbeitung durch das ChatGPT-Modell aufgeteilt wird. Ein Token kann ein einzelnes Zeichen, eine Wortgruppe oder sogar ein Teil eines Wortes sein, je nachdem, wie der Text aufgebaut ist. Das Modell analysiert und verarbeitet den Text auf der Ebene dieser einzelnen Tokens.

⮑ 59 Wörter · 137 Tokens · Verhältnis: 2,32

Prompt: Schreibe 5 Nachrichtenschlagzeilen

Natürlich! Hier sind fünf Nachrichtenschlagzeilen:

"Neue Studie zeigt: Sportliche Aktivitäten steigern die geistige Leistungsfähigkeit"

"Regierung beschließt umfassende Klimaschutzmaßnahmen zur Reduzierung der Treibhausgasemissionen"

"Wissenschaftler entdecken neue Behandlungsmethode für bisher unheilbare Krankheit"

"Internationales Gipfeltreffen vereinbart Maßnahmen zur Förderung des globalen Friedens"

"Innovative Technologie revolutioniert die Art und Weise, wie wir kommunizieren"

Diese Schlagzeilen dienen nur zu illustrativen Zwecken und sind nicht auf tatsächliche Ereignisse bezogen.

⮑ 81 Wörter · 260 Tokens · Verhältnis: 3,21

Prompt: Schreibe eine Überschrift für die Landing-Page einer Schwimmschule.

"Tauche ein in ein neues Schwimmerlebnis: Entdecke unsere Schwimmschule!"

⮑ 19 Wörter · 52 Tokens · Verhältnis: 2,74

Diese Beispiele zeigen, dass es sich bei der Faustregel auch nur um eine Faustregel handelt und ein festes Verhältnis nicht festgelegt werden kann.

Mehr im ChatGPT Kurs

Die ChatGPT Masterclass von einer der größten Website zu KI bereitet dich perfekt auf den Umgang mit KI-Chatbots vor. Egal welches Wissenslevel du hast, du lernst garantiert etwas.

Weiterführende Artikel

Hands-on zu Tokens und der API-Einbindung bei apidog (englisch)