NVIDIA stellt neue AI Foundry und NIM Inference Microservices mit Llama 3.1 vor

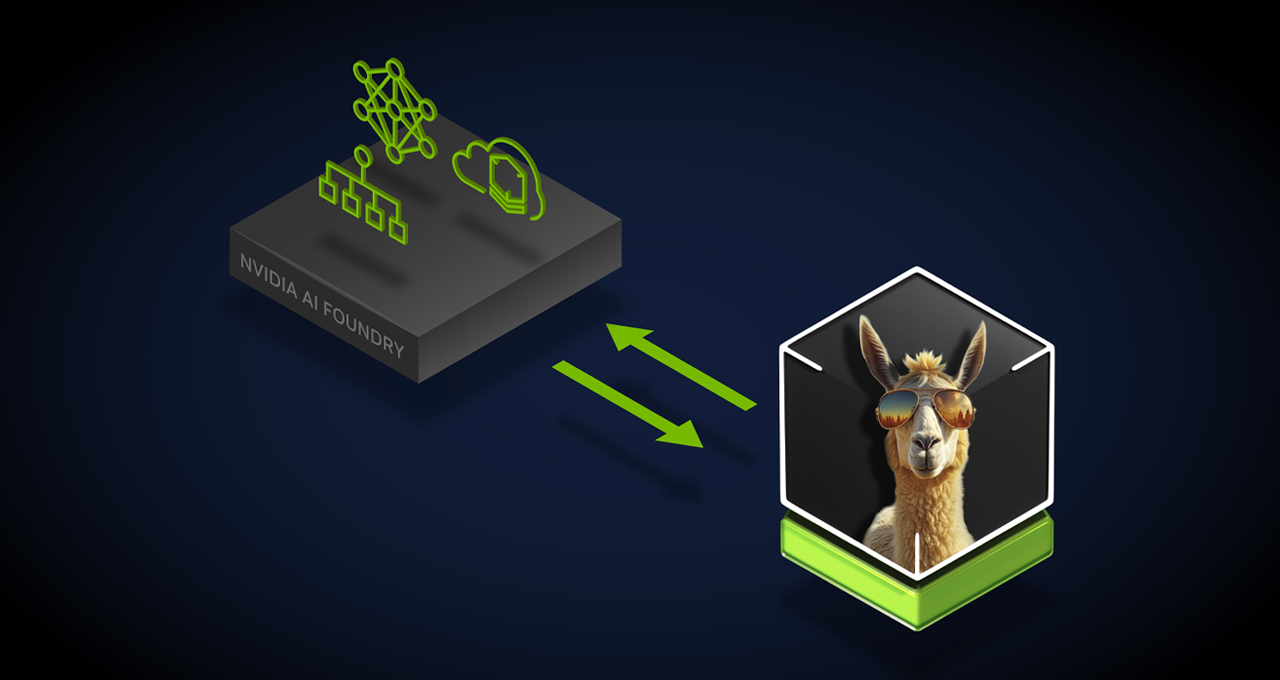

NVIDIA hat die Einführung seines neuen AI Foundry Service und der NVIDIA NIM Inference Microservices bekannt gegeben, die darauf abzielen, die Fähigkeiten generativer KI für Unternehmen weltweit zu verbessern. Diese neuen Angebote, die zusammen mit der Llama 3.1 Modellkollektion vorgestellt wurden, ermöglichen es Unternehmen und Nationen, maßgeschneiderte KI-Modelle für spezifische Branchenanwendungen zu erstellen.

Bildquelle: Nvidia

Der AI Foundry Service von NVIDIA bietet Unternehmen die Möglichkeit, sogenannte „Supermodelle“ zu entwickeln, die auf den Llama 3.1 Modellen und NVIDIA-Technologien basieren. Diese Modelle können mit proprietären Daten sowie synthetischen Daten, die von Llama 3.1 405B und dem NVIDIA Nemotron™ Reward Modell generiert wurden, trainiert werden. Die Plattform wird von der NVIDIA DGX™ Cloud AI unterstützt, die in Zusammenarbeit mit führenden Cloud-Anbietern entwickelt wurde und Unternehmen skalierbare Rechenressourcen bietet.

Das Interesse an maßgeschneiderten großen Sprachmodellen mit domänenspezifischem Wissen wächst, besonders bei Unternehmen und Nationen, die eigene KI-Strategien entwickeln. Mit den neuen NIM Inference Microservices können Unternehmen Llama 3.1 Modelle schnell und effizient in die Produktion bringen. Diese Microservices bieten eine bis zu 2,5-fach höhere Durchsatzleistung im Vergleich zu herkömmlichen Methoden.

NVIDIA AI Foundry ermöglicht es Unternehmen, eigene Modelle zu erstellen und diese mit den NVIDIA NeMo Plattformen zu kombinieren. Dies beinhaltet auch die Nutzung des NVIDIA Nemotron-4 340B Reward Modells, um die Modellgenauigkeit weiter zu verbessern. Für Unternehmen, die zusätzliche Trainingsdaten benötigen, bietet NVIDIA die Möglichkeit, synthetische Daten zu generieren und bestehende Modelle anzupassen.